【Stable Diffusion】ControlNetの線画用モデル『canny』の使い方を解説!

- ※当ブログはアフィリエイト・アドセンスによる収益で運営されています。

こういったお悩みにお答えします。

Stable Diffusionに必須と言っても過言ではない拡張機能のControlNetですが、さまざまなモデルが。それぞれに特徴が違うため、どう使い分ければいいのかわかりづらいですよね。

openposeしか使っていない方も多いのでは?

この記事では

- 【Stable Diffusion】ControlNetの線画用モデル『canny』の特徴とは?

- ControlNetの線画用モデル『canny』の導入方法

- ControlNetの線画用モデル『canny』の使い方

- もっとスムーズにイラストを生成したいなら…

- 生成した大量のイラストを簡単に管理する方法

これらについて解説していくので、最後まで読むとcannyの特徴や使い方がわかります。

この記事ではControlNetの『canny』というモデルについて解説していますが、ControlNet全体や他のモデルについて知りたい方は以下の記事も合わせてお読みください。

>>【Stable Diffusion】拡張機能ControlNetの使い方を解説!

【Stable Diffusion】ControlNetの線画用モデル『canny』の特徴とは?

ControlNet用モデルの一つ『canny』はCanny edge detectionというアルゴリズムに基づいて抽出された線画情報を扱うのが特徴。元画像の線画情報を保ったまま新しいイラストを生成したい場合に重宝します。

ザックリ言うと『元画像の色を変えたい』というケースでcannyを選択することが多いでしょう。

『線画情報ってなに?』という方は以下の画像をご覧ください。

このイラストの線画情報を抽出すると

こんな感じです。

cannyを使うと

- 元となる画像から線画情報を抽出

- 線画情報をもとに新しいイラストを生成

この流れで作業が行われます。

線画情報をベースにするということは、(線画に影響しない)他の情報を変更するのが簡単ということ。

元画像の線画を保ったまま

髪などの色を変えたいときに有効活用しましょう。

その一方、線画情報自体を変更しづらいのがcannyの特徴です。上のイラストだと、猫耳を消そうとしてもなかなか消えてくれません。抽出された線画には猫耳の形もばっちり描かれていますからね。

目的によってimg2imgやopenposeなどと使い分けるのがおすすめです。

ControlNetの線画用モデル『canny』の導入方法

cannyを導入するには、前提としてControlNetという拡張機能の導入が必須です。

ControlNet未導入の方は以下の記事を参考にインストールしておいてください。

>>【Stable Diffusion】拡張機能ControlNetの使い方を解説!

ControlNet導入済みの方は

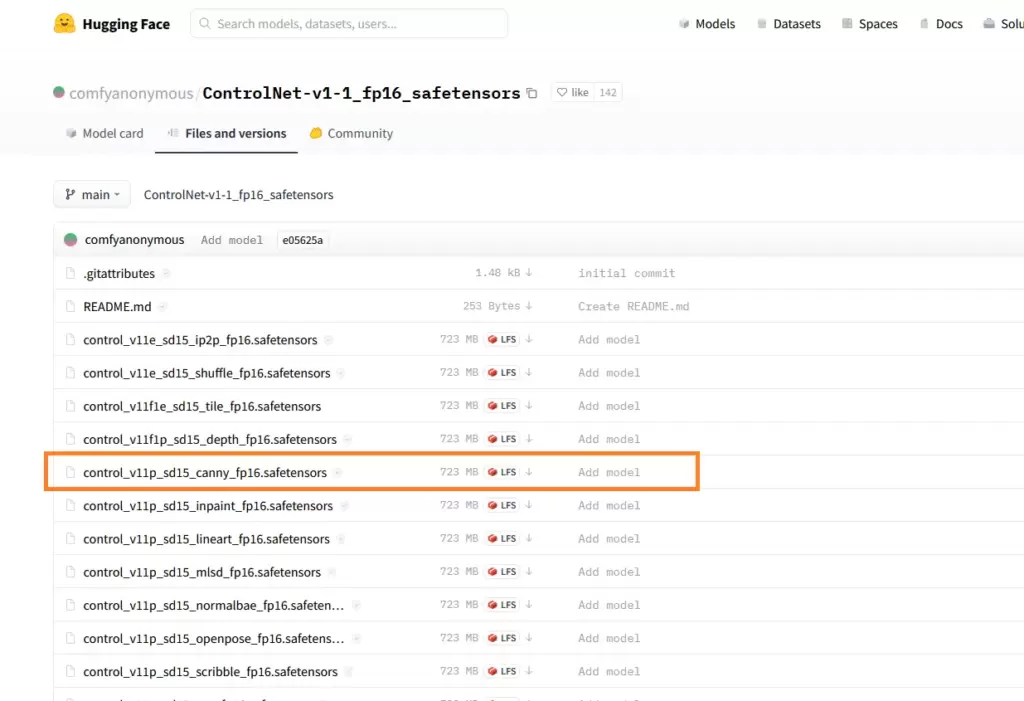

Hugging faceに飛び

- control_v11p_sd15_canny_fp16.safetensors

という約700MBのファイルを入手してください。

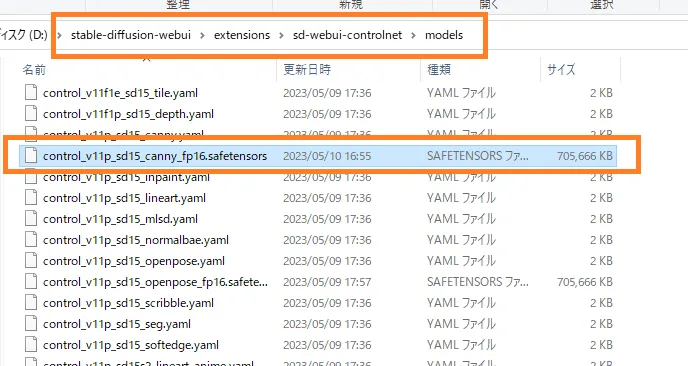

ダウンロードが完了したら

『stable-diffusion-webui』→『extensions』→『sd-webui-controlnet』→『models』の中に放り込めば完了です。

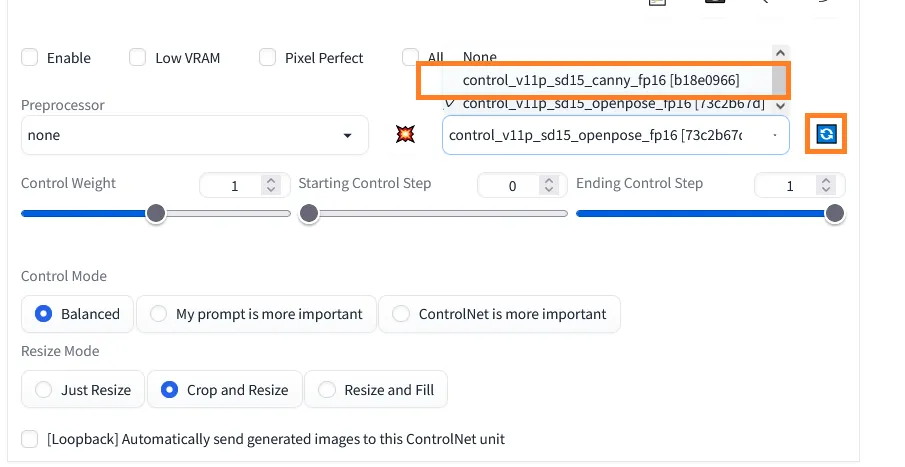

その後はStable Diffusionを再起動してもいいですし

ControlNet内のモデル選択画面で更新アイコンを押すことでも追加したモデルが反映されます。

ControlNetの線画用モデル『canny』の使い方

実際にControlNetでcannyを使っていきましょう。

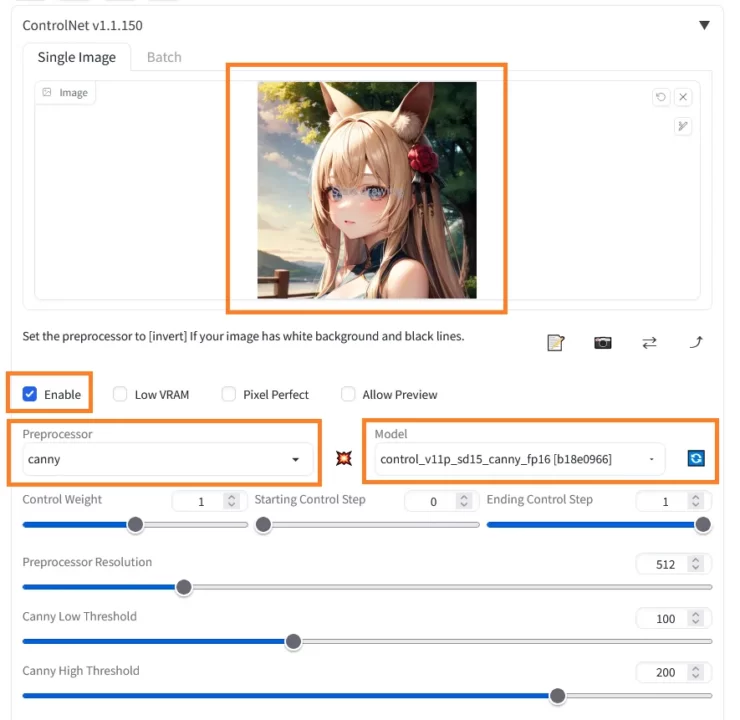

この画像の線画情報を抽出し、髪の色だけ変えていきます。

- Prompt:masterpiece,best quality,1girl,black hair

- Negativeprompt:EasyNegative

こんなプロンプトを入力し、元画像の金髪を黒髪に変えてみましょう。

Stable Diffusionの操作画面からControlNetのタブを開き

- 参考にする画像をドラッグ&ドロップする

- Enableにチェックを入れる

- Preprocessor:canny

- Model:control_v11p_sd15_canny_fp16

- 他の項目:そのまま

これらの設定が完了したら『Generate』を押してイラストを生成すると

黒髪のイラストができあがったのではないでしょうか。

もちろん『black hair』の代わりに他の色を指定することも可能です。Wildcardを使うと

ランダムでたくさんの髪色を試し、その中から選ぶこともできます。

背景や服装の色についても同じ手順で変更できるので、ぜひcannyを使って遊んでみましょう。

ただし、画像から色情報を受け取らないことはcannyのデメリットにもなり得ます。

例えば、上の画像では背景の色がコロコロ変わっていますよね。基準となる色情報がなく、毎回オリジナルで描画するためです。

『元画像の背景の色彩はそのままに、髪の色だけ変えたい』という場合はまた違った工夫が必要になりそう。inpaintで範囲指定しながらcannyを使ったり。いろいろと試してみてください。

もっとスムーズにイラストを生成したいなら…

もしあなたがもっと快適にAIイラストを生成したいなら、グラボを見直してみるのがおすすめです。

グラボはAIイラストを生成するうえで最も重要なパーツ。いくらCPUやメモリが高性能でもグラボがしょぼかったら致命的です。

本格的に取り組んでいくのなら、グラボにはケチらず投資しましょう。最低でも12GBのVRAMは確保しておきたいところ。VRAMが2GB・4GBくらいしかない古いグラボだと高解像度化や学習に大きな支障が出てしまいます。

コスパを重視する方・予算が5万円以下の方はRTX 3060一択と言っていいでしょう。

もう少し予算が確保できて、さらにハイスペックなグラボに興味がある方は以下の記事もお読みください。きっとあなたに合ったグラボが見つかりますよ。

>>【コスパ重視】Stable Diffusionにおすすめのグラボ3選!

PCごと買い替えを検討している方は以下の記事をお読みください。快適にStable Diffusionを使えるマシン3選を紹介しています。

>>Stable Diffusionにおすすめのパソコン3選と推奨スペックを解説!

生成した大量のイラストを簡単に管理する方法

Stable Diffusionで生成した大量のイラストを効率的に管理するなら『Eagle』というツールがおすすめ。

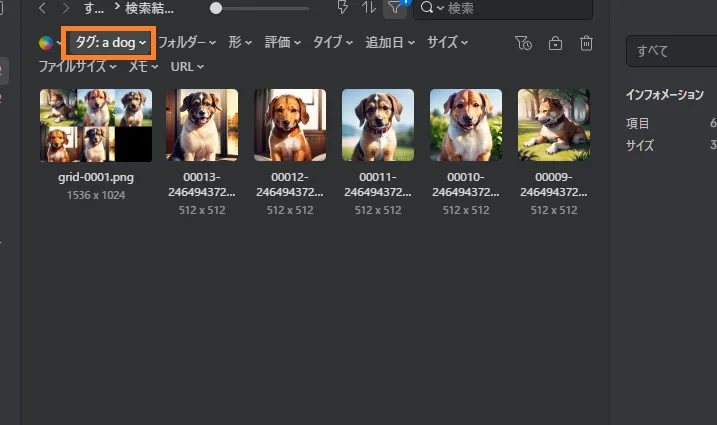

イラストを生成するとメタデータが自動でEagleに送られ、タグやメモとして保存されます。このタグを使うことで検索や管理がとても楽ちん。

例えば『a dog』というタグで検索すると、そのプロンプトで生成されたイラストだけを表示することができます。『あのイラストどんなプロンプトで生成したっけ?』『LoRAのトリガーワード忘れた』なんて迷わずに済みますよ。

Eagleは本来『約4,000円・買い切り型』の有料ツールですが、30日間の無料体験ができるので、とりあえず試してみてください。

『【Stable Diffusion】ControlNetの線画用モデル『canny』の使い方を解説!』のまとめ

- cannyはControlNetで使えるモデルの一つ

- 線画情報を抽出し、それをもとにイラストを生成してくれる

- 輪郭を保ったまま色を変えたいときなどに使ってみよう

ここまでお読みいただきありがとうございました!

他にもわからないことがあったら以下の記事をお読みください。初心者向けにStable Diffusionの使い方を一から解説しています。