【Stable Diffusion】AI画像から動画へ!拡張機能『AnimateDiff』の使い方・導入方法!

こういったお悩みにお答えします。

2022~2023年にかけて爆発的に技術が発展・普及してきたAIイラスト。それに続いて、2023年の後半ごろからAI動画の分野も徐々に進化してきています。

しかし『AIイラストは作れるようになったけど、動画はさっぱり…』という方も多いのではないでしょうか。

正直まだまだ発展途上なAI動画ですが、拡張機能を使えばローカルのWeb UIでもアニメーション動画を生成することが可能です。

この記事では

- AI画像から動画へ!拡張機能『AnimateDiff』の特徴は?

- AnimateDiffの導入方法

- AnimateDiffの使い方・設定

- もっとスムーズにイラストを生成したいなら…

- 生成した大量のイラストを簡単に管理する方法

- NegPIPに関するよくある質問

これらについて解説していくので、最後まで読むとAnimateDiffという拡張機能を使って、AI動画を生成することができるようになります。

AnimateDiff以外のおすすめ拡張機能を知りたい方は以下の記事も合わせてお読みください。

>>Stable Diffusionでおすすめの拡張機能(Extensions)を紹介!

AI画像から動画へ!拡張機能『AnimateDiff』の特徴は?

AnimateDiffはStable Diffusionをベースにしたアニメーション生成機能。有志により開発され、ComfyUI上でもWeb UI上でも動かすことができます。

AnimateDiffを使うと、テキストやイラストからアニメーション動画を作ることが可能に。AI技術の進歩の速さを感じますね。

この記事では、最もユーザー数が多いであろうWeb UI上でAnimateDiffを使用する方法について解説していきます。

AnimateDiffの導入方法

AnimateDiffはWeb UI上で使える拡張機能として配付されています。導入には

- 拡張機能『AnimateDiff』の導入

- モーションモジュールのダウンロード

この2STEPが必要。順番に解説していきますね。

拡張機能『AnimateDiff』の導入

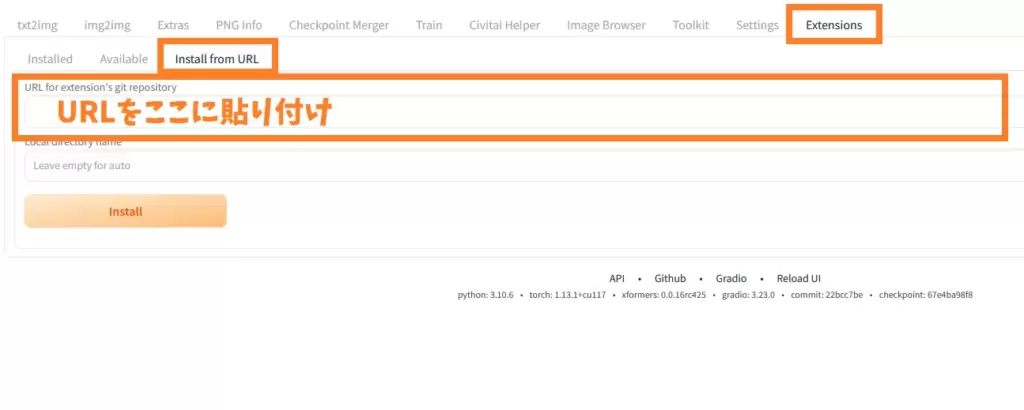

Stable Diffusion web UIの操作画面で『Extension』→『Install from URL』タブを選択し

- https://github.com/continue-revolution/sd-webui-animatediff

このURLをコピペしてください。

下にある『Install』ボタンを押すと、自動でインストールが始まります。

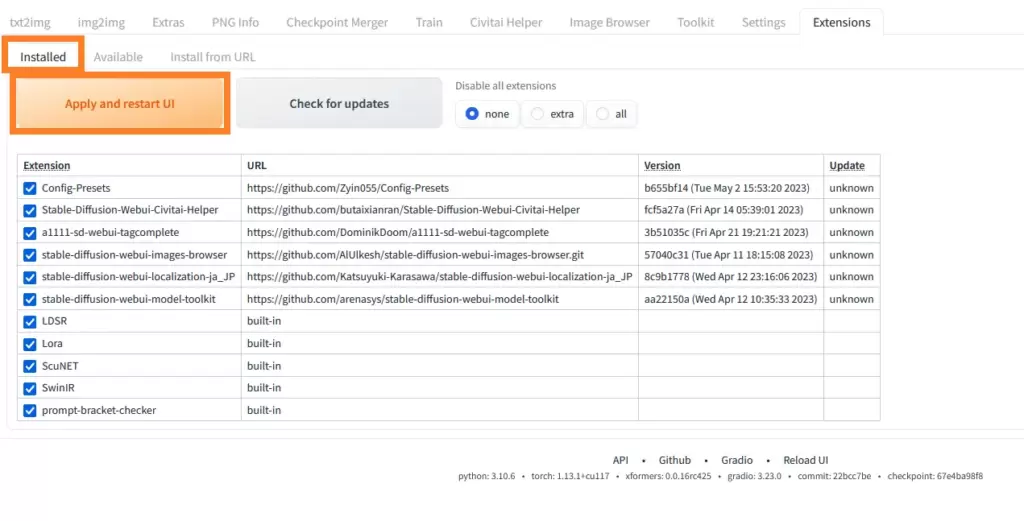

インストールが完了したら『installed』のタブに移動し、『Apply and restart UI』ボタンをクリックしましょう。Stable Diffusionが再起動され、AnimateDiffが適用されます。

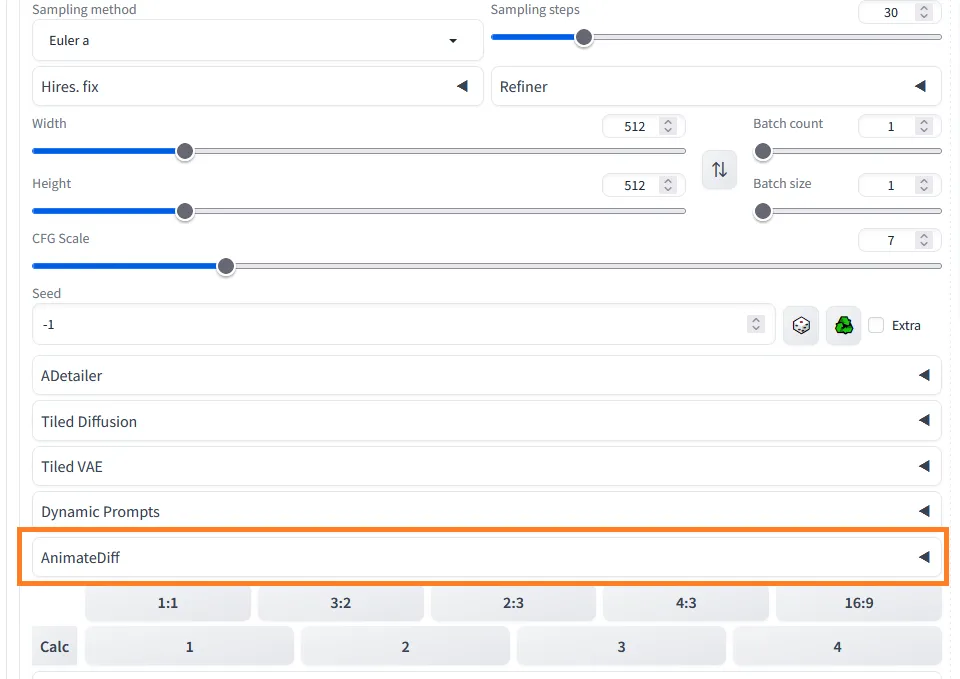

再起動後、Web UIの左下に『AnimateDiff』と表示されていれば導入は完了です。

モーションモジュールのダウンロード

通常の拡張機能と違い、AnimeDiffを使うには『モーションモジュール』というファイルが必要です。これは一般的な動作を学習させたもの。このファイルを基にキャラクターが動きます。

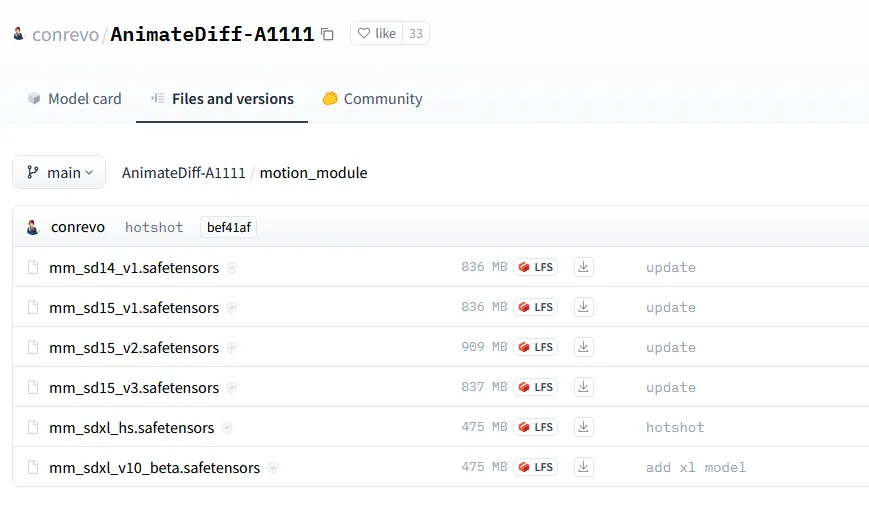

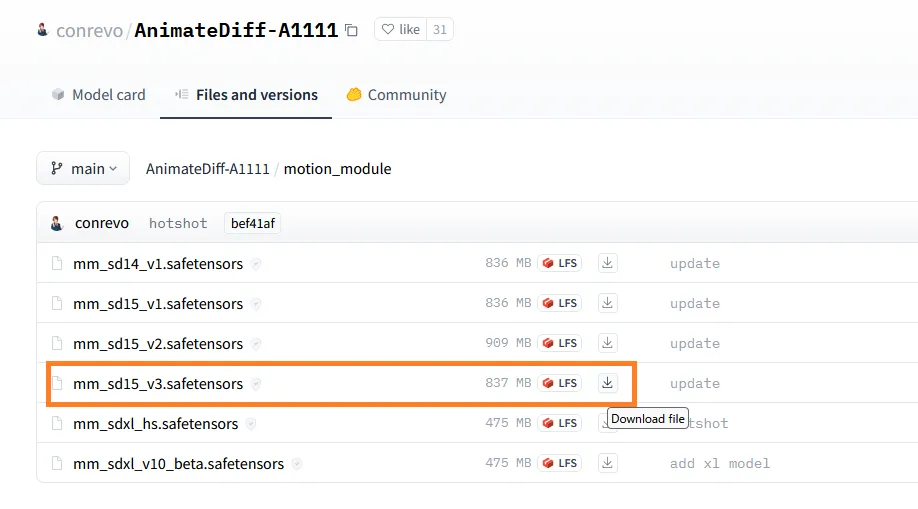

出典元:Huggingface

Huggingfaceから好きなモーションモジュールをダウンロードしましょう。バージョンによって動きの質が少し異なります。

この記事では2024年1月時点で最新の『mm_sd15_v3.safetensors』を使ってAI動画を生成してみます。

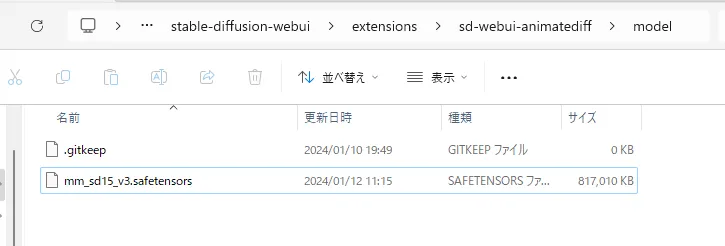

ダウンロードしたファイルは

-

stable-diffusion-webui/extensions/sd-webui-animatediff/model

上記フォルダの中に放り込みましょう。これで準備はOKです。

AnimateDiffの使い方・設定

細かい機能や設定は後回しにして、まずはAI動画を1本(Text to Videoで)作ってみましょう。

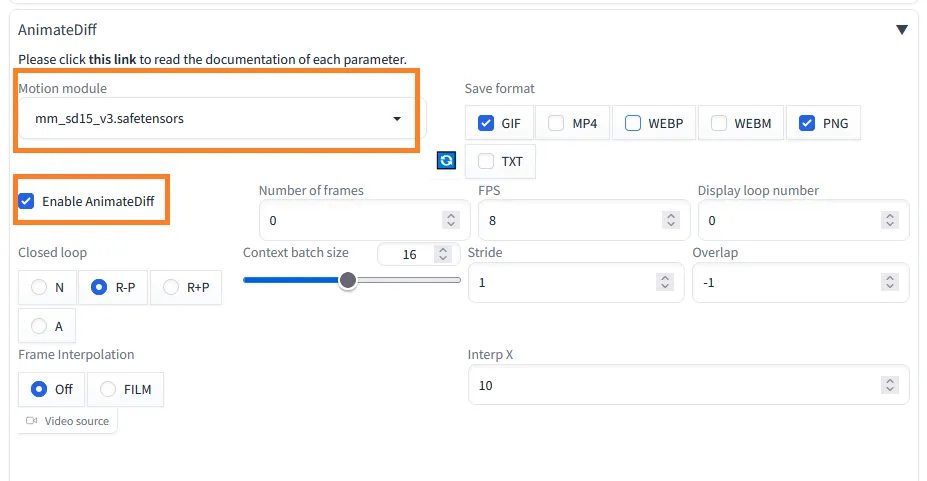

Web UIにあるtxt2imgのタブ内で『AnimateDiff』を開き

- モーションモデルを選ぶ

- Enable AnimateDiffにチェック

とりあえずこの2つだけで動画を作ることはできます。

適当なプロンプトを入力し、いつもどおり『Generate』をクリックすると

このような短いGif動画ができあがります。

筆者の環境だと、生成にかかった時間は20秒くらい。わりと気軽に試せるので、そこそこのグラボ(VRAM12GBあれば大丈夫そう)をお持ちの方はぜひ動画生成にトライしてみてください。

AnimateDiffに関する各種設定

とりあえず動画の生成ができたところで、AnimateDiffに関する代表的な設定項目を確認していきましょう。

サイズ・Sampling method

イラスト生成時になじみのあるこれらの項目は動画生成時にも重要です。

サイズを大きくすると破綻が多くなるのはイラストと同じ。基本的には512×512周辺のサイズで生成しましょう。

Sampling methodに関しては、イラスト生成よりもシビアな印象です。動画生成に合うものと合わないものがあるようで、筆者が試した範囲では

- DDIM

- DPM++ 2M SDE Karras

これらのSampling methodが比較的よさそうに感じました。

Save format

生成した動画を保存する形式です。GIFやMP4などが選べますが、筆者の環境ではMP4ではうまく保存できませんでした。

Number of frames・FPS

生成する合計フレーム数と、1秒間に再生されるフレーム数。Number of frames:16フレームでFPS:8に設定すれば2秒分の動画が生成されます。

フレーム数が多いほどGPUへの負担が増えることに加え、破綻も多くなるのでほどほどにしておくのがおすすめです。

Closed loop

動画のループに関する設定。『Number of frames』の値が『Context batch size』より大きい場合にのみ有効です。

そのほか詳しくは開発者のページ(GitHub)をお読みください。

ControlNetとの併用も可能

AnimateDiffはControlNetとも併用できるのがすごいところ。

例えば弱めにTileを適用すると、動きが抑えられる代わりにちらつきや破綻が少なくなります。

もちろんopenposeやcannyなども使用可能なのでいろいろ遊んでみてください。

img2imgでは既存のイラストをベースに動画を生成可能

img2img上でAnimateDiffを使うと、放り込んだイラストをベースに動画を生成することができます。

ただしDenoising strengthが小さすぎるとうまく動画にならず、大きすぎると元のイラストから絵柄が離れてしまうため調節が難しい印象です。

もっとスムーズにイラストを生成したいなら…

もしあなたがもっと快適にAIイラストを生成したいなら、グラボを見直してみるのがおすすめです。

グラボはAIイラストを生成するうえで最も重要なパーツ。いくらCPUやメモリが高性能でもグラボがしょぼかったら致命的です。

本格的に取り組んでいくのなら、グラボにはケチらず投資しましょう。最低でも12GBのVRAMは確保しておきたいところ。VRAMが2GB・4GBくらいしかない古いグラボだと高解像度化や学習に大きな支障が出てしまいます。

コスパを重視する方・予算が5万円以下の方はRTX 3060一択と言っていいでしょう。

もう少し予算が確保できて、さらにハイスペックなグラボに興味がある方は以下の記事もお読みください。きっとあなたに合ったグラボが見つかりますよ。

>>【コスパ重視】Stable Diffusionにおすすめのグラボ3選!

PCごと買い替えを検討している方は以下の記事をお読みください。快適にStable Diffusionを使えるマシン3選を紹介しています。

>>Stable Diffusionにおすすめのパソコン3選と推奨スペックを解説!

生成した大量のイラストを簡単に管理する方法

Stable Diffusionで生成した大量のイラストを効率的に管理するなら『Eagle』というツールがおすすめ。

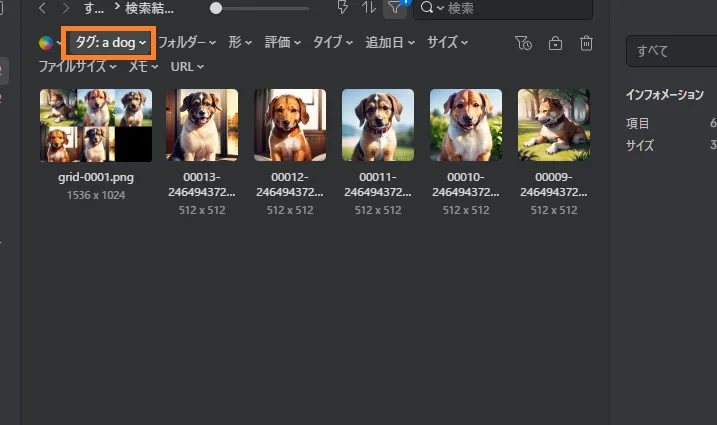

イラストを生成するとメタデータが自動でEagleに送られ、タグやメモとして保存されます。このタグを使うことで検索や管理がとても楽ちん。

例えば『a dog』というタグで検索すると、そのプロンプトで生成されたイラストだけを表示することができます。『あのイラストどんなプロンプトで生成したっけ?』『LoRAのトリガーワード忘れた』なんて迷わずに済みますよ。

Eagleは本来『約4,000円・買い切り型』の有料ツールですが、30日間の無料体験ができるので、とりあえず試してみてください。

『【Stable Diffusion】AI画像から動画へ!拡張機能『AnimateDiff』の使い方・導入方法!』のまとめ

- AnimateDiffはAI動画を生成できる拡張機能

- txt2imgでもimg2imgでも使用可能

- ちらつきなど、現状ではまだまだ課題が多いが面白い

ここまでお読みいただきありがとうございました!

他にもわからないことがあったら以下の記事をお読みください。初心者向けにStable Diffusionの使い方を一から解説しています。