【Stable Diffusion】既存の動画からAI動画を生成できる『mov2mov』の使い方

- ※当ブログはアフィリエイト・アドセンスによる収益で運営されています。

こういったお悩みにお答えします。

Stable Diffusionは画像生成AIとして有名ですが、応用することで動画にも(ちょっとだけ)対応することが可能。今後は動画生成に焦点が移っていく中で、乗り遅れないよう早めに触っておきたいですね。

この記事では

- 【Stable Diffusion】既存の動画からAI動画を生成できる『mov2mov』の特徴とは

- mov2movの導入方法

- mov2movの使い方

- mov2movで生成した動画について検証

- もっとスムーズにイラストを生成したいなら…

- 生成した大量のイラストを簡単に管理する方法

これらについて解説していくので、最後まで読むとmov2movを使って既存の動画からAI動画を生成する方法がわかります。

初心者の方・Stable Diffusionに関してわからないことがある方は以下の記事も読んでみてください。Stable Diffusionのダウンロード方法や使い方について詳しく解説しています。

>>【完全初心者用ガイド】Stable Diffusionの使い方を徹底解説!

【Stable Diffusion】既存の動画をAI動画に変換できる『mov2mov』の特徴とは

Stable Diffusionでは『mov2mov』という機能を使うことによって、既存の動画をベースにしたAI動画を生成することができます。

この記事で紹介するmov2movの仕組みは

- 元となる動画を1フレームごとに解析

- 選択したControlNetのモデルで情報を抽出

- 抽出した情報をもとにイラストを生成

こんな流れです。静止画に対してimg2imgを繰り返し、それをつなげて動画にするイメージ。元動画ありきの作業ですね。

『ゼロからAI動画を作りたい』という方も多いでしょうが、技術的にはまだ難しい状況。文章(プロンプト)から動画を生成する『txt2mov』が実用的になるのは、まだしばらく先のことでしょう。

まずはtxt2movよりもハードルが低いmov2movからAI動画生成に取り組んでみるのがおすすめです。

mov2movの導入方法

mov2mov機能を使うには

- ControlNetのインストール

- Multi ControlNetの有効化

これら2つの準備が必要。

まだ導入していない方は以下の記事を参考に準備を進めてみてください。

>>【Stable Diffusion】拡張機能ControlNetの使い方を解説!

>>【Stable Diffusion】Multi ControlNetとは?使い方と導入方法を解説!

上記2つの導入が完了したら、mov2mov用の拡張機能をインストールします。

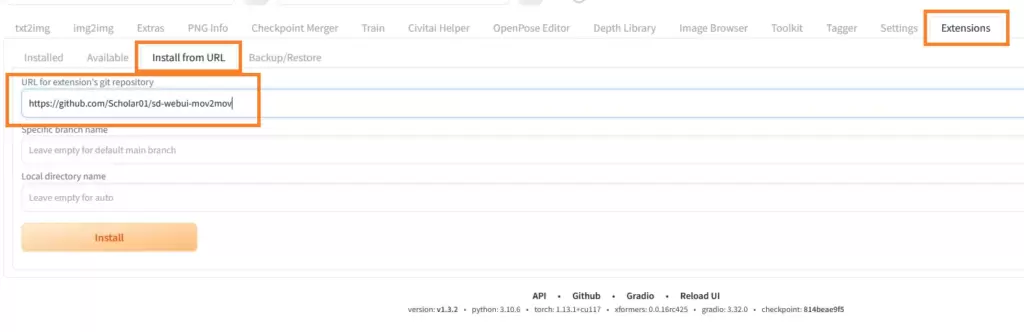

『Extensions』→『Install from URL』タブを開き

- https://github.com/Scholar01/sd-webui-mov2mov

と入力して、画面下のインストールボタンを押しましょう。

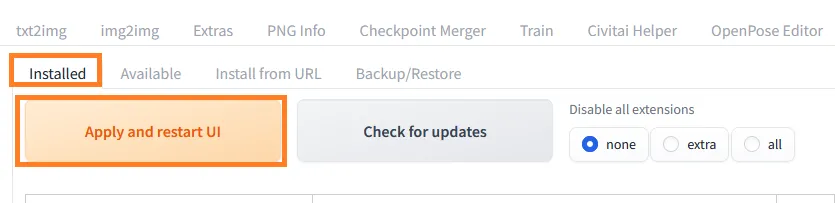

インストールが完了したら、左側の『Installed』タブからUIを再起動してください。

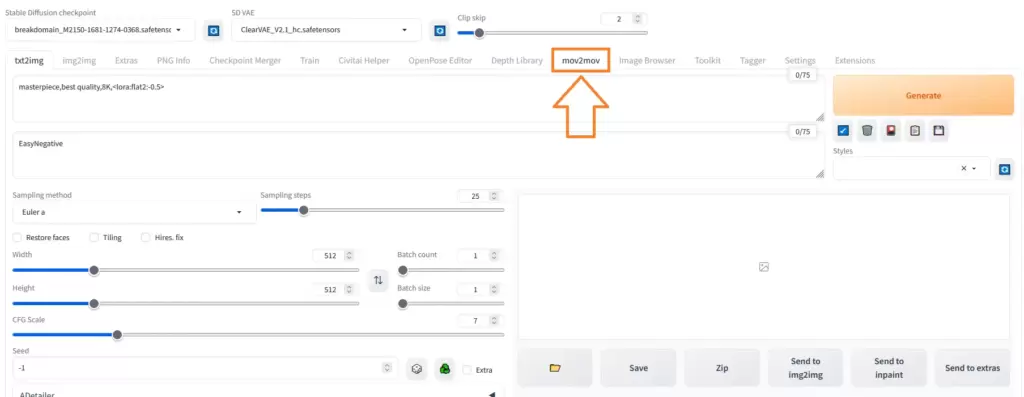

再起動後、『mov2mov』のタブが追加されていれば導入完了です。

mov2movの初期設定

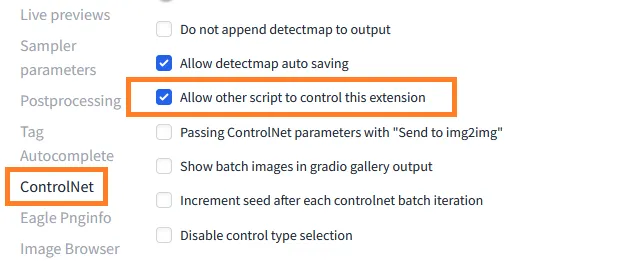

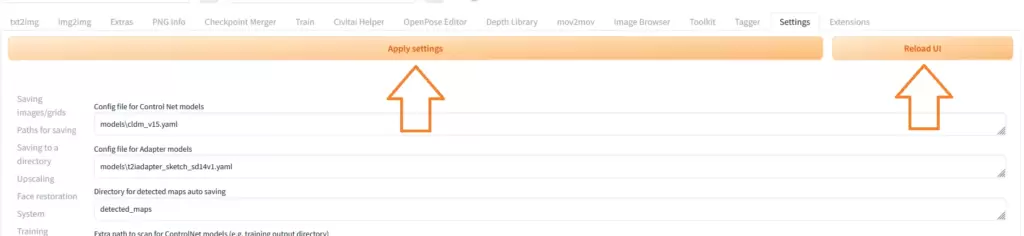

mov2movを導入したら『Settings』→『ControlNet』→『Allow other script to control this extension』にチェックを入れておきましょう。未チェックだとmov2movを使ったときにエラーになってしまいます。

設定を変更したら『Apply settings』→『Reload UI』を押すのをお忘れなく。

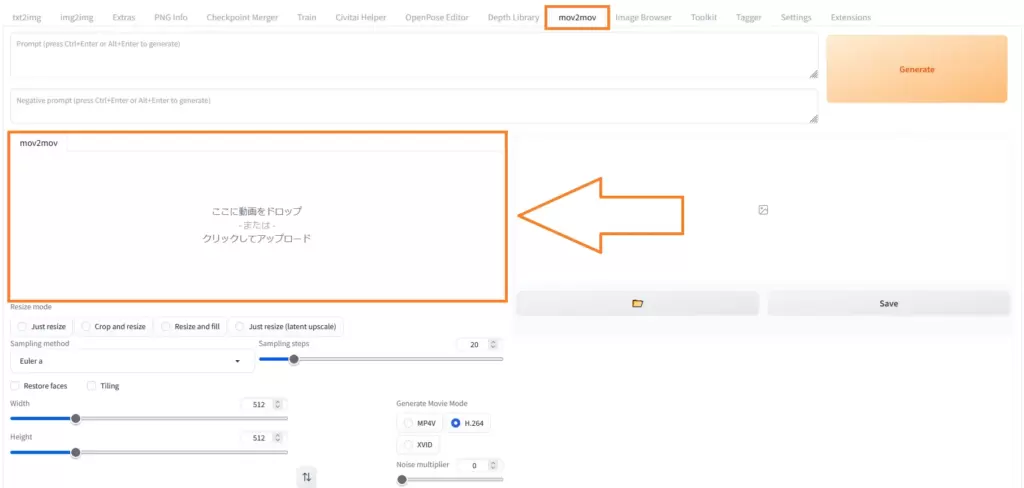

mov2movの使い方

mov2movタブを開いたら、元になる動画を放り込みましょう。

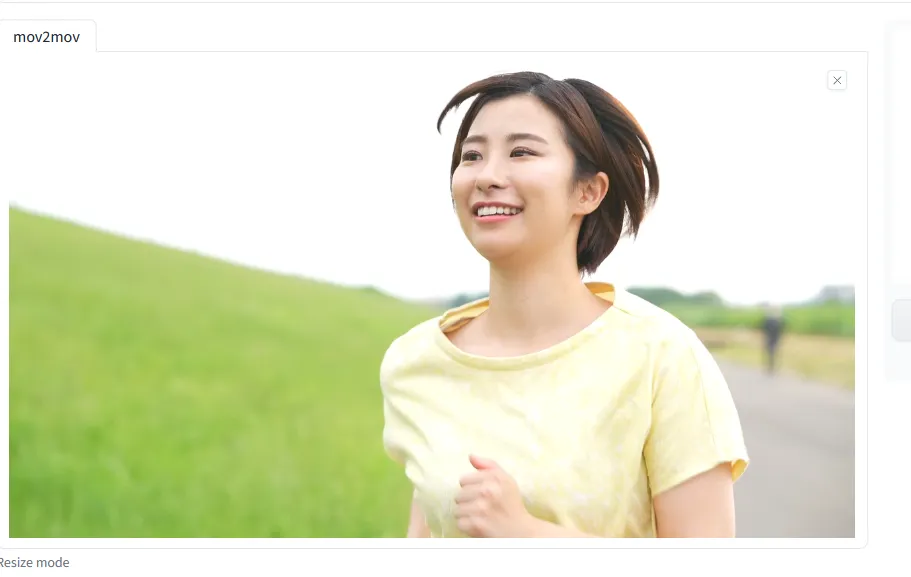

この記事では、フリーサイトからダウンロードした

女性が走っている動画をベースにmov2movを試していきます。

基本的な使い方は

- プロンプト・ネガティブプロンプトを入力

- Sampling methodなどを設定

- ControlNetのモデルを選択

こんな流れです。順番に解説していきますね。

プロンプト・ネガティブプロンプトを入力

- プロンプト:masterpiece,best quality,8K

- ネガティブプロンプト:EasyNegative

まずはシンプルにクオリティタグのみにしておきます。

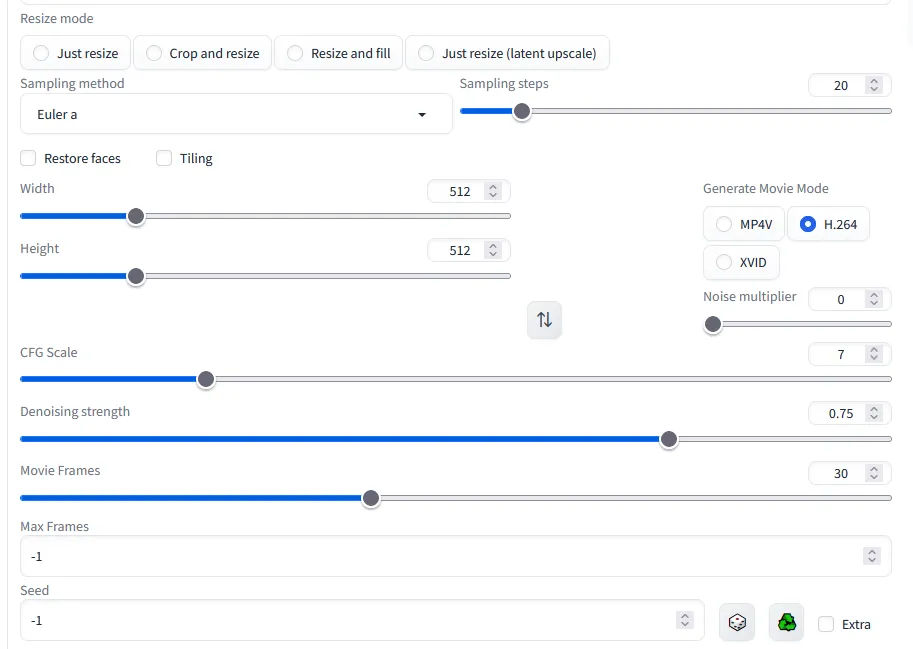

Sampling methodなどを設定

Resize mode

考え方はimg2imgと同じです。この記事では『Just resize』にします。

Sampling method・Steps・サイズ・CFG Scale

お好みで。

Generate Movie Mode

これもお好みで大丈夫ですが、MP4V以外ではエラーが出てしまう方もいるようです。

Denoising strength

動画のできあがりに大きく影響します。とりあえず0.7に設定しておきますが、詳しくは後ほど。

Movie Frames

生成後の動画を何フレームにするか。数字を大きくするとイラストが高速で切り替わるため、目がちかちかしやすいです。25~30くらい推奨。

Max Frames・Seed

とりあえず『-1』のままでOK。

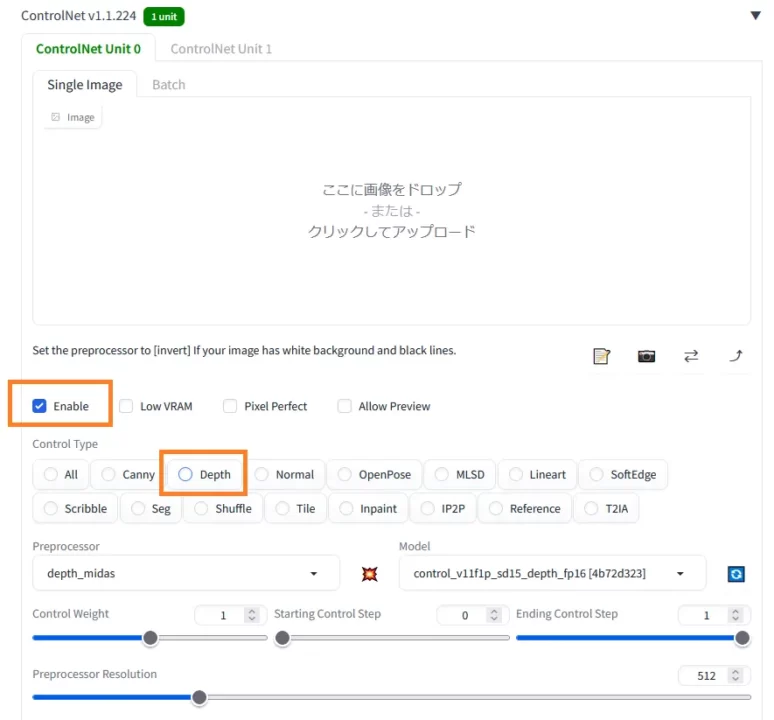

ControlNetのモデルを選択

ControlNetの画像は空欄のままで、Enableにチェックをつけましょう。

モデルは『Depth』を選択します。その他の項目は初期値のままでOK。

元の動画1秒に対して何十枚ものイラストを生成するため、うっかり長尺の動画を放り込むととんでもなく時間がかかります。mov2movを試しに使うときは数秒くらいの短い動画をベースにしましょう。

mov2movで生成した動画について検証

ここまでの設定内容で生成すると、こんな動画ができあがりました。

※動画生成後に別の動画編集ソフトを使って、速度10%でゆっくりと再生しています。

Depthのみだと深度情報だけを頼りにしてイラストを生成するので

人物が後ろ向きになったり、性別や特徴がコロコロ変わったりします。色の情報も抽出できないので、背景の色もぜんぜん違いますね。

MultiControlNetを使用

今度はMultiControlNetを使って2つ(Depth+Softedge)のモデルを併用してみましょう。

Softedgeを使うことで、人物が後ろ向きになるようなことはなくなりました。このように、それぞれのモデルの弱点を補うイメージで併用するのがおすすめです。

Depth+Softedgeの場合でも、キャラクターの性別や特徴が変わってしまうのは相変わらず。背景の色もおかしいですね。次はもっと一貫性を重視してみましょう。

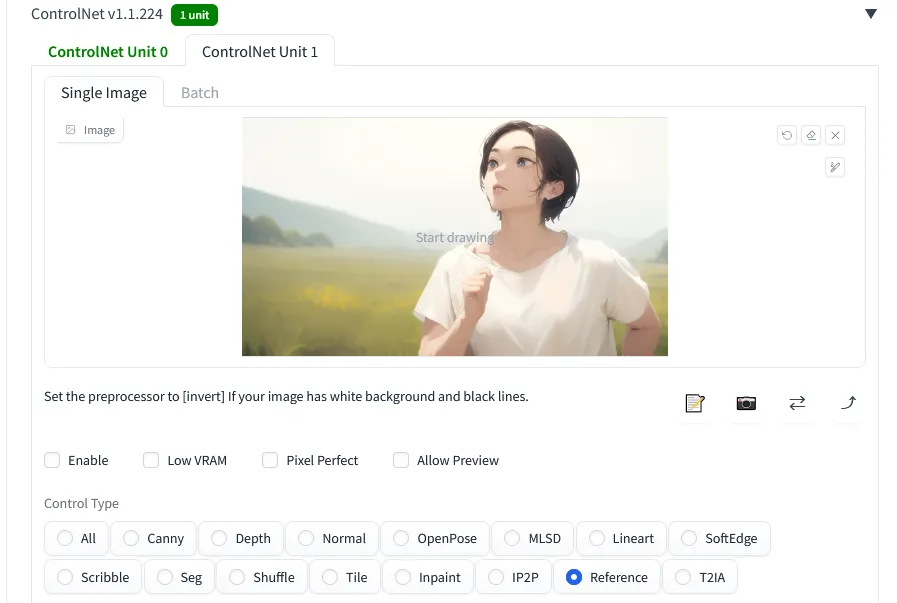

reference onlyを併用

『一貫性と言えばreference only』ということで、reference only+Softedgeで動画を生成します。

このイラストをControlNetに入れて、キャラクターを固定してみましょう。

結構いい感じではないでしょうか。キャラクターだけでなく、背景の一貫性も保たれていますね。

mov2mov機能を使うときはreference onlyを軸に考えていくのがよさそうです。

Denoising strengthは0.7以上推奨

Denoising strengthの値は0.7以上にしておくのがおすすめです。Depthモデルでの例を見てみましょう。

『0.3』『0.5』『0.7』それぞれのパターンで比べてみると、『0.3』『0.5』ではかなりぼやけた印象。はっきりとした動画を作りたい場合は、Denoising strengthの値を0.7以上に設定しておきましょう。

なおアニメ動画 → アニメ動画に変換する場合など、筆者が試していないパターンも多いのでご参考まで。

プロンプトによる制御も有効

プロンプトでキャラクターの特徴を指定することで、自分好みの動画に近づけることもできます。

先ほどまでの動画では、特に指定しなかったため女性が描かれていました。プロンプトで『child female』『old woman』とそれぞれ入力してみると

できあがりはこんな感じに。

元動画からイメージを変えることも可能なので、いろいろと試してみてください。

もっとスムーズにイラストを生成したいなら…

もしあなたがもっと快適にAIイラストを生成したいなら、グラボを見直してみるのがおすすめです。

グラボはAIイラストを生成するうえで最も重要なパーツ。いくらCPUやメモリが高性能でもグラボがしょぼかったら致命的です。

本格的に取り組んでいくのなら、グラボにはケチらず投資しましょう。最低でも12GBのVRAMは確保しておきたいところ。VRAMが2GB・4GBくらいしかない古いグラボだと高解像度化や学習に大きな支障が出てしまいます。

コスパを重視する方・予算が5万円以下の方はRTX 3060一択と言っていいでしょう。

もう少し予算が確保できて、さらにハイスペックなグラボに興味がある方は以下の記事もお読みください。きっとあなたに合ったグラボが見つかりますよ。

>>【コスパ重視】Stable Diffusionにおすすめのグラボ3選!

PCごと買い替えを検討している方は以下の記事をお読みください。快適にStable Diffusionを使えるマシン3選を紹介しています。

>>Stable Diffusionにおすすめのパソコン3選と推奨スペックを解説!

生成した大量のイラストを簡単に管理する方法

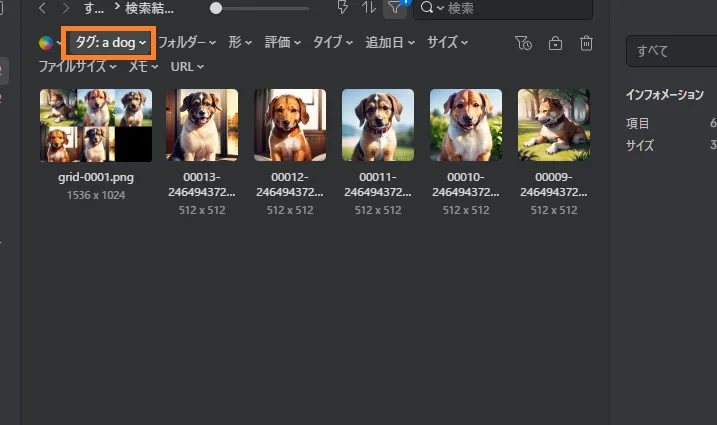

Stable Diffusionで生成した大量のイラストを効率的に管理したいなら『Eagle』というツールがおすすめ。

イラストを生成するとメタデータが自動でEagleに送られ、タグやメモとして保存されます。このタグを使うことで検索や管理がとても楽ちん。

例えば『a dog』というタグで検索すると、そのプロンプトで生成されたイラストだけを表示することができます。『あのイラストどんなプロンプトで生成したっけ?』『LoRAのトリガーワード忘れた』なんて迷うことがなくなります。

Eagleは本来『約4,000円・買い切り型』の有料ツールですが、30日間の無料体験ができるので、とりあえず試してみてください。

『【Stable Diffusion】既存の動画からAI動画を生成できる『mov2mov』の使い方』のまとめ

- mov2movを使うと既存の動画をベースにAI動画を生成できる

- reference onlyを活用して一貫性を保とう

- AI動画生成はまだまだ発展途上

ここまでお読みいただきありがとうございました!

他にもわからないことがあったら以下の記事をお読みください。初心者向けにStable Diffusionの使い方を一から解説しています。